SelectelTechDay

21 сентября в Санкт-Петербурге в актовом зале компании Selectel состоялась конференция SelectelTechDay, организованная компаниями Selectel и Intel, на которой представители этих компаний рассказали какие технологии и облака внедряет Selectel, как они помогают расти разным сегментам бизнеса, как в ЦОДах используется продукция Intel. Об этом начал свой рассказ директор по развитию бизнеса компании Selectel Игорь Сысоев. SelectelTechDay был ориентирован на IT-директоров, партнеров, разработчиков и инженеров.

Кирилл Малеванов, технический директор компании Selectel выступил с докладом «Новый data-центр: тенденции развития в техническом плане и прогнозы на будущее».

Оптимизация и модернизация инфраструктуры ЦОДа требуется практически сразу после его строительства, поскольку разработанная инфраструктура достаточно быстро морально устаревает. Модернизация инфраструктурных решений в компании Selectel направлена на снижение конечной цены продуктов IaaS при высоком качестве и бесперебойной работе этих продуктов. Сейчас существует большое число новинок в развитии инфраструктуры ЦОДов.

«Selectel в 2010 году построил data-центр, в котором использовалась чиллерная схема климатоснабжения, она оказалась очень капризной в случае применения в помещениях с источниками бесперебойного электропитания. Потребовалось два года, чтобы эта схема перестала приносить головную боль при эксплуатации. Кстати, бывает трудно объяснить корпоративным заказчикам, что температура в data-центре в 24-27 градусов соответствует современным американским стандартам комиссии по климатоснабжению. Клиенты говорят, что в таком-то году было написано, что в серверной должно быть до 18 градусов. Однако и оборудование вендоров хорошо работает при 40-42 градусах», - сказал Кирилл Малеванов.

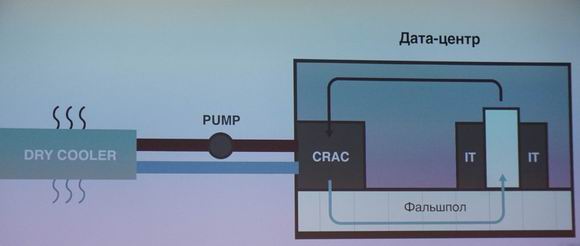

Классическая схема по климатоснабжению: кондиционеры охлаждают воздух за счет перехода фреона из одного агрегатного состояния в другое. Этот воздух под фальшполом поступает в «холодные коридоры», проходя через работающее оборудование и выходя через «горячие коридоры» опять попадает в кондиционеры. По этой схеме был построении ЦОД («Цветочная, 1») в 2008 году.

Развивая тему климатоснабжения появилось и чиллерное холодоснабжение. Чиллер – это аппарат для охлаждения жидкости, использующий парокомпрессионный или абсорбционный холодильный цикл. После охлаждения в чиллере жидкость может подаваться в теплообменники для охлаждения воздуха (фанкойлы). Чиллер отличается от кондиционера в первую очередь тем, что он охлаждает воздух не переходя в другое агрегатное состояние, используется для этих целей этиленгликоль или пропиленгликоль. Затем он поступает на внешние блоки, которые могут включаться в случае повышенной температуры окружающей среды. По этой схеме были построении ЦОДы («Дубровка, 1») в 2010 году и («Цветочная, 2») в 2015 году. Последний рассчитан на предоставление услуг collocation. Внешние блоки чиллера включаются тогда, когда температура окружающего воздуха выше 12-15 градусов, что позволяет экономить электроэнергию.

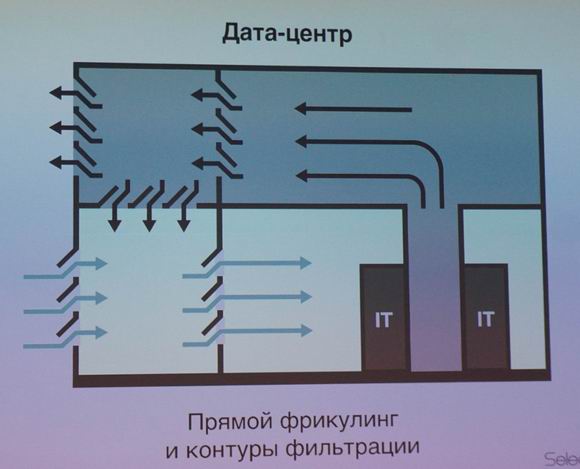

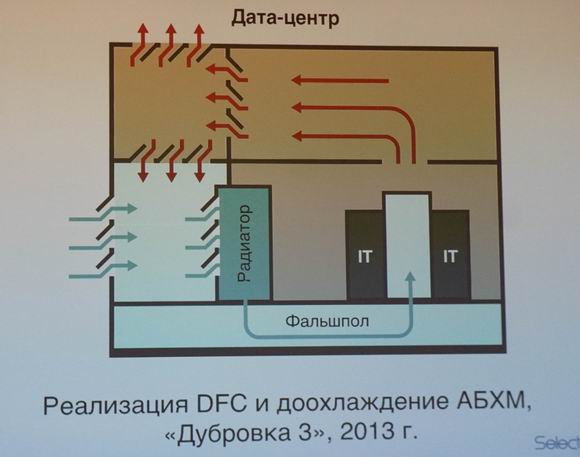

Дальнейшее совершенствование системы охлаждения пошло при использования воздуха окружающей среды, поскольку современные стандарты позволяют держать температуру в ЦОДе на уровне не выше 27 градусов. Появилось решение по прямому фрикулингу (см. схему). Воздух поступает из окружающее среды, проходит через фильтры в машинный зал. Для поддержания его в рамках заданной температуры горячи воздух идет через камеру смешения.

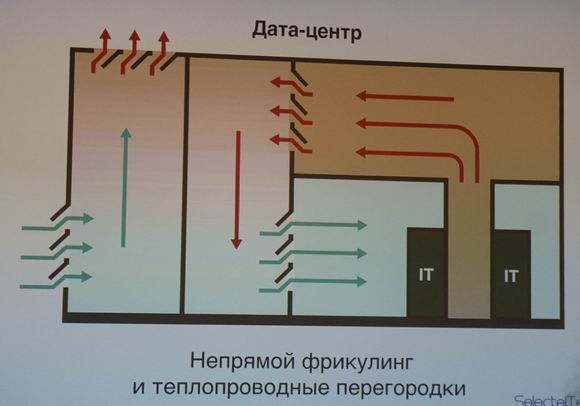

Прямой фрикулинг не всегда является оправданным, поскольку необходимы большие расходы на воздушные фильтры, если data-центр находится в зоне загрязненного воздуха. В этом случае применяется непрямой фрикулинг, который использует теплопроводные перегородки (см. схему). «При строительстве новых ЦОДов по фрикулинг-схеме не обязательно делать фальшпол, поскольку у нас нет кондиционеров, которые дуют под пол. За холодный коридор принимается все окружающее пространство, а горячий коридор выделяется фальшпотолком, т.е. вместо фальшпола используется фальшпотолок», - уточнил Кирилл Малеванов.

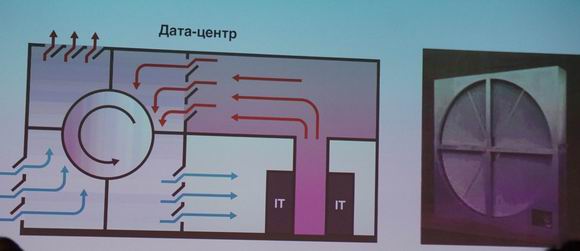

Примером такого непрямого фрикулинга является теплопроводное колесо Kyoto, которое может быть расположено и горизонтально, и вертикально. В этом случае не происходит прямого забора воздуха из окружающей среды, что значительно экономит затраты на фильтры. Колесо Kyoto требует больших капитальных расходов, поскольку само оно достаточно дорого и кроме того для него требуется проектировать двухэтажный ЦОД, поскольку колесо и горячий коридор занимают дополнительный этаж.

Следующая схема: прямой фрикулинг с доохлаждением обычными фреонными блоками (см. схему). В результате мы получили на «Цветочная, 1» показатель использования электроэнергии PUE=1,7 то есть на сервер мощностью 1 кВт мы тратим 700 Вт на его охлаждение. На площадке «Дубровка, 3», где используется прямой фрикулинг с доохлаждением, получен коэффициент PUE=1,2. В планах на двух других площадках – получение PUE=1,15.

Затем Кирилл Малеванов рассказал о новинках в электроснабжении ЦОДов и ИБП. «Мы сравнили обычные свинцовые батареи, устанавливаемые в ИБП, с Li-ion-батареями, с суперконденсаторами и использованием физических маховиков для сохранения кинетической энергии. Все эти технологии очень перспективны, но на сегодняшний день капитальные расходы по их закупке значительно превышают суммарную стоимость владения обычно схемы на свинцовых батареях. Поэтому, из расчета окупаемости data-центра на 10 лет, свинцовые батареи на сегодня являются оптимальным решением.

Отвечая на вопрос об оптимальности схемы охлаждения Кирилл Малеванов сказал: «Для collocation оптимальной будет чиллерная схема, для собственных услуг – это прямой фрикулинг без доохлаждения».

Затем с докладом «Уникальные возможности: взаимодействие Intel и Selectel» выступил Василий Бояринов, директор корпоративных продаж по Восточной Европе, Intel.

Интересный доклад «Новая серверная архитектура Intel: конвергенция памяти и систем хранения» сделал Михаил Цветков, инженер, технический консультант, Intel, на нем мы остановимся подробнее.

Центры обработки данных нуждаются в производительных, надежных и энергоэффективных средствах обработки и хранения информации, способных работать с большими потоками и объемами данных. Правильный выбор процессорной архитектуры оказывает большое влияние на показатели эффективности и масштабируемости используемых решений. При этом важнейшими характеристиками являются увеличение пропускной способности шин обмена данными между ядрами, кэшем процессора, контроллером памяти и подсистемой ввода/вывода. С целью уменьшения задержек и увеличения скорости передачи данных для ЦОД следующего поколения компания Intel разработала процессоры Intel Xeon Scalable.

В этих изделиях вместо традиционной Ring Architecture (см. рис.) с кольцевым доступом к компонентам процессора реализована Mesh Architecturе (mesh — «решетка»). В новом решении процессорные ядра, кэш, контроллеры памяти и контроллеры ввода/вывода упорядочены в строки и столбцы, между которыми находятся шины и переключатели, позволяющие данным перемещаться по требуемым маршрутам в рамках решетки. Это обеспечивает увеличение количества маршрутов для передачи сигнала на фоне сокращения преодолеваемых расстояний. Как результат, достигнуты высокая производительность и низкие задержки; потоки данных хорошо масштабируются для многопроцессорных (многосокетных) конфигураций. Поддерживается технология Intel VMD, позволяющая изолировать проблемные устройства для горячей замены и обработки ошибок, упрощает программный стек PCIe хранилища. Платформы с Intel Xeon Scalable рекомендуется использовать для современных виртуализированных гибридных и гиперконвергентных data-центров.

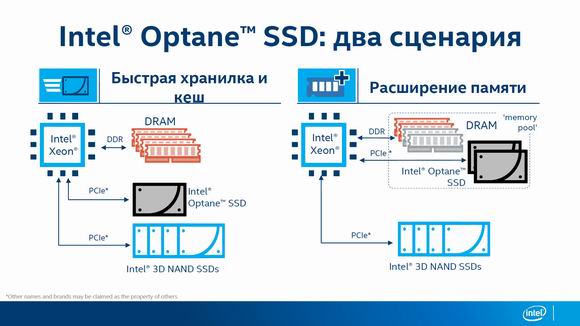

Кроме процессоров, важной составляющей архитектуры ЦОД являются системы хранения информации. Долгое время для этого использовались дисковые подсистемы, созданные на основе массивов HDD, являвшимися, по сути, безальтернативными устройствами. Однако ситуация стала меняться после появления твердотельных накопителей (SSD). Лишенные движущихся механических элементов и созданные на основе микросхем флэш-памяти типа NAND, SSD обеспечивают по сравнению с HDD более высокие скорости передачи данных, меньшие задержки доступа к данным, меньшие показатели энергопотребления и теплообразования, большую надежность. Переход на флэш-память 3D NAND позволил повысить надежность и ресурс SSD. Однако, как считают инженеры Intel, следующий этап связан с переходом на флэш-память 3D XPoint. Компания не раскрывает подробностей принципов работы флеш-памяти, что не снижает ее достоинств. Созданные на ее основе накопители получили наименование Optane. В настоящее время для ЦОД компания Intel предлагает накопители Intel Optane SSD DC P4800X, ориентированные на корпоративный сегмент. По своей идеологии это продукты находятся на стыке обычной динамической памяти (DRAM) и флеш-памяти типа NAND. Накопители Intel Optane SSD DC P4800X позволили пересмотреть традиционную архитектуру обработки данных.

Они обеспечивают новый уровень в иерархии систем хранения информации (см. рис.). Подключаются через шину PCI Express. В отличие от традиционных NAND SSD со странично-блочной организацией работы накопители Intel Optane SSD DC P4800X обеспечивают, как и в случае памяти DRAM, байтную адресацию. Демонстрируют очень высокую производительность: на операциях чтения/записи блоками 4 Кбайт производительность достигает 550 тыс. IOPS. Выносливость — 30 DWPD (перезаписей в день), что примерно в три раза больше лучших альтернативных моделей твердотельных накопителей. По сравнению с NAND SSD у Intel Optane SSD DC P4800X задержки доступа меньше более чем в 10 раз, они в 5-8 раз быстрее на низких очередях, а при 99% QoS преимущество может достигать 60 раз. Накопители оптимальны для приложений критичных к требованиям по задержкам.

При этом время отклика не меняется от нагрузки. Указанные характеристики расширяют сферу применения накопителей семейства Optane. Кроме использования в качестве привычных хранилищ программ и данных, эти устройства благодаря высоким скоростным параметрам и побайтному способу адресации хорошо интегрируются в подсистему оперативной памяти (см. рис.).

Это позволяет уменьшить нагрузку на DRAM, снизить требуемый объем и стоимость владения. В заключение представитель Intel рассказал о некоторых примерах применения платформ с Intel Xeon Scalable и накопителями Intel Optane.

Опубликовано 29.09.2017