Data-Driven: что такое «решения на основе данных»?

Что мы имеем в виду, говоря, что решения в организации принимаются на основе данных? Неужели в доцифровую эпоху компании работали как-то иначе? Конечно же, нет: любые отчеты, документы и сводки всегда основывались на данных — о продажах, клиентах, зарплатах и других важных для компании вещах.

Но можно ли доверять этим данным? Насколько точно мы знаем, откуда взялись все эти цифры и показатели? Сколько времени придется потратить, чтобы получить отчет? И не устареют ли данные к тому моменту, когда мы сможем ими воспользоваться?

Суть подхода Data-Driven состоит именно в том, чтобы любой бизнес-пользователь, от топ-менеджера до рядового сотрудника, мог по первому же запросу быстро (то есть в течение минут, а не дней!) получить нужные ему сведения. При этом данные должны быть достоверными, качественными и актуальными, и сотрудник должен точно знать, что на них можно опереться.

Чтобы этого добиться, нужны две вещи:

-

Правильный подход к работе с данными. Его первый и обязательный элемент — четкая постановка бизнес-задач, то есть понимание, для чего бизнесу нужны эти данные и каких целей он хочет достичь, работая с ними. Не менее важно распределить ответственность между сотрудниками, которые будут с этими данными работать: понять, кто будет отвечать за какой участок, как будет построено проектирование данных, какое качество данных требуется и какие задачи будут поставлены разработчикам.

-

Непосредственно технологии, с помощью которых этот подход будет реализован.

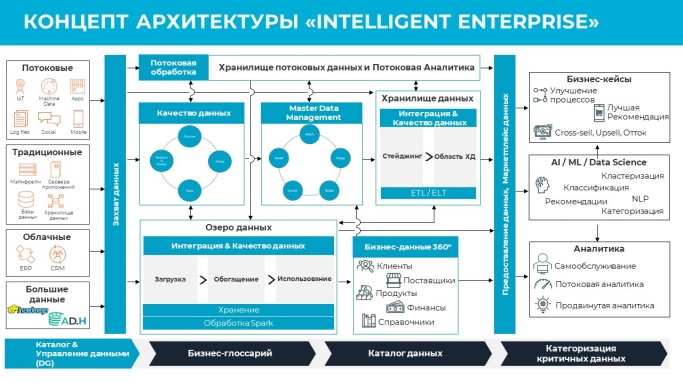

Эталонная архитектура управления данными

Каким будет решение по управлению данными, зависит от задач конкретной компании. Для работы с данными существует классическая архитектура, из которой можно выбрать один или несколько модулей для реализации:

-

Хранилище данных идеально подходит в том случае, если ваша главная задача — быстрая подготовка точных и достоверных отчетов, меняющихся не очень часто, без глубокого анализа данных и построения прогностических моделей.

-

Озеро данных предназначено как раз для аналитики. Особенно хорошо это решение работает в организациях, у которых накоплено много данных в разных форматах, сложной структуры или даже неструктурированных.

-

Фабрика данных представляет собой «конвейер гипотез». На основании качественных, структурированных и каталогизированных данных она позволяет выполнять аналитику «на лету», в режиме онлайн. Такие решения очень востребованы, например, в современных банках, формирующих персональное предложение для каждого из десятков тысяч своих клиентов.

-

Data Mеsh — подход, появившийся относительно недавно. Его основное преимущество — возможность разделить фактически одни и те же данные для разных подразделений, чтобы они (подразделения) не мешали друг другу при использовании данных для решения своих задач.

Все эти варианты архитектуры помогают пользоваться данными наиболее эффективно. В зависимости от выбранного варианта компании внедряют у себя подходящие инструменты работы с данными.

Must-have-инструменты для управления данными

Для сбора, хранения и обработки данных необходимы технологии традиционных реляционных хранилищ данных.

Под этими элементами должен находиться единый интеграционный слой, который технологически разделяется на решения по работе с хранилищами данных и с Big Data. Интеграцию данных обеспечивают решения класса ETL (Extract, Transform, Load). Они позволяют доставлять любые данные из любых источников и «положить» их в ту структуру хранения, которую вы выберете: хранилище, озеро, Data Mesh или любую другую. Но здесь важно понимать, что каждый ETL-инструмент должен иметь удобный визуальный интерфейс для разработки, чтобы передача знаний между командами (которые регулярно меняются) была удобной и быстрой. Не менее важно, чтобы производительность ETL-решений была высокой вне зависимости от того, какие системы выступают источниками и приемниками информации.

Безусловно, необходимы технологии управления качеством данных, причем как на этапе загрузки, так и на этапе, связанном с хранением данных, их передачей в витрины, отчеты и т. д. Строго говоря, все «этажи» этого «здания» должны быть пронизаны сквозным управлением качеством. Обязательный шаг — внедрение корпоративных бенчмарков качества. Они нужны, чтобы у всех подразделений было единое понимание того, что считать качественными данными и по каким метрикам.

Системы управления метаданными — важные инструменты, необходимые для реализации подходов Data Governance и Data-Driven. Нельзя обойтись без иерархического бизнес-глоссария, привязанного к организационной структуре, и инструмента управления им. ИT-мир оперирует названиями таблиц, но этот язык непонятен бизнесу. Чтобы ИT и бизнес заговорили на одном языке, и создается бизнес-глоссарий, содержащий не только иерархию терминов, но и фактически иерархию их паспортов.

Что такое паспорт данных? Он содержит наименование данных, описывает методику их получения, рекомендации к трактовке, привязку к организационной структуре, бенчмарку качества и нормативно-правовым аспектам, а также показывает, кто в организации отвечает за эти конкретные данные и заинтересован в них.

Требуются также технологии и решения, позволяющие построить карту трансформации данных и каталогизировать их. Это технология Data Catalog.

Она позволяет создать картотеку, где содержится структурированный, иерархизированный каталог метаданных физического слоя и используемые трансформации при передаче данных или визуализации.

Наконец, часть корпоративных данных может представлять собой коммерческую тайну. Такие данные можно назвать чувствительными. К ним же относятся персональные данные, данные о счетах и операциях и многое другое. Необходимы решения по защите чувствительных данных: технологии создания тестовых копий и сред, маскирования данных, управления доступом к этим данным и т. д.

Подход важнее инструментов?

Какие бы инструменты и архитектуру вы ни выбрали, работать они будут только в том случае, если в компании сформирован правильный подход к управлению данными.

Первым шагом к нему будет понимание, как именно нужно работать с запросами на данные. Современный подход, вне зависимости от выбранных технологий, предполагает, что в случае поступления запроса на данные от любого бизнес-пользователя сразу можно увидеть, какими данными мы уже располагаем, какого они качества, какие из них уже предоставлялись раньше и могут быть переиспользованы. Можно ли дать этому конкретному пользователю доступ к этим конкретным данным? Достаточный ли у них уровень качества? Если нет, можно ли его повысить, или же тратить время на работу с такими данными нецелесообразно? Если же данные удовлетворяют всем критериям, то как правильно передать им аналитикам, на логическое проектирование и далее на разработку?

Используемый подход должен покрывать все этапы работы с метаданными и данными с момента поступления запроса от пользователя до момента предоставления ему результата.

Вопросов много, но если ответить на них правильно и сформировать на их основе единый подход к работе с данными для всей компании, то процессы пойдут намного быстрее, чем при «традиционном» подходе, когда бизнес-аналитики и системные аналитики зачастую раскоординированы. Из-за этого на выполнение задач тратится больше времени и возникает очередь на получение данных. В этом и кроется первопричина ситуации, когда нужный отчет приходится ждать три месяца, и к моменту получения данные в нем уже безнадежно устаревают.

***

Таким образом, инструменты, технологии и архитектура — это все-таки вторичные вещи, хотя недооценивать их не следует. Превращение организации в Data-Driven начинается не с покупки решений, а с понимания бизнес-задач и построения на их основе правильного подхода к работе с данными.

Опубликовано 21.12.2022