Борьба с дипфейками в реальном времени набирает обороты

Признак нынешнего времени — стремительный рост объема публикуемых фейков. За последние несколько лет количество фальшивых фото- и видеоматериалов росло невероятными темпами. Они распространялись через социальные сети и онлайн-платформы, ими пользовались не только шутники, но и злоумышленники и даже, по слухам, государственные службы.

Особую роль в развитии популярности фейков сыграли достижения в области искусственного интеллекта (ИИ). Они позволили создавать поддельные изображения и видео с настолько высоким уровнем реализма, что для фейков новой волны появилось даже новое название — «дипфейки».

Термин «дипфейк» (от deepfake) изначально был придуман пользователем Reddit в 2017 году для своего ника в социальной сети. «Развлечением» этого «персонажа» было применение готовых ИИ-инструментов для подстановки лиц знаменитостей в видеоклипы. Тема сразу стала полузапретной, потому что автор использовал видеоклипы преимущественно порнографического содержания.

Но технология получила продолжение и стала активно развиваться. Сегодня к дипфейкам относят уже все виды манипуляций с изображением лица, когда техническими средствами ИИ и компьютерной графикой создается имитация присутствия постороннего лица в месте, где оно не было на момент съемки.

Примеры дипфейков

Распространение дипфейков получило неоднозначную реакцию в интернет-сообществах. Много споров вызвал проект LiveStory компании MyHeritage, которая предоставила пользователям возможность анимировать старые фотографии родственников, добавляя им голос.

Дошло до того, что южнокорейская телекомпания MBN объявила об экспериментальном использовании этого метода для в своих новостных материалах: применить дипфейк взамен постоянной ведущей Ким Чжу-Ха. Компьютерная версия диктора настолько точно повторяла ее голос, жесты и даже мимику, что многие зрители узнав о подставе, решили потом, что популярный диктор скоро потеряет работу.

Конечно, дипфейки стали активно применяться и там, с чего все начиналось — для создания порнографии. В сети очень быстро появились веб-сайты, позволяющие пользователям «обнажать» любого человека, предоставив системе его изображения.

Достижения в генерации дипфейков сразу привлекли и сатириков. Так, британский канал Channel 4 разместил дипфейковое видео с рождественским посланием королевы Елизаветы II. Но они не учли менталитет английской публики — этот дипфейк вызвал бурю протестов в стране, многие призывали бойкотировать ТВ-канал.

Женщина из Южной Кореи «общается» со своей умершей дочерью

Со своими «причудами» скоро выступила и Южная Корея. Один из ее ТВ-каналов пригласил в студию жительницу страны — мать недавно умершей девочки. С помощью технологии дипфейка компьютерщики «реанимировали» умершую дочь и дали матери возможность «пообщаться» с цифровой копией девочки, используя технологии виртуальной реальности. На женщину надели VR-шлем и дали тактильные перчатки. Инженеры использовали реальные фото и видео покойной девочки, а также аудиозаписи ее голоса. Это позволило воспроизвести в виртуальной реальности то, что никогда не могло произойти в реальности.

В 2022 году новый всплеск дипфейков был связан с событиями на Украине. «Киберударами» обменялись обе стороны — участницы конфликта. Так, в марте на местном ТВ-канале появилось фейковое видео с президентом Украины. Он вышел на подиум и сделал заявление о капитуляции Украины. Но зрители отметили непропорциональный размер головы спикера, неестественную пикселизацию его тела и более низкий голос. Дипфейк появился в результате взлома сайта.

Дипфейк с президентом Украины на ТВ-канале «Украина 24»

Аналогичный дипфейк произошел и с другой стороны. В том же месяце в Twitter появился ролик с президентом России, где он объявлял о достижении перемирия и прекращении боевых действий на Украине, добавив о восстановлении независимости Крыма. На следующий день после этого в сети появилось видео о разбомбленном украинском театре. Было это правдой или нет, многие из знающих предысторию уже сомневались.

Дипфейк с президентом России на канале в Twitter

Как распознать дипфейки?

Появление многочисленных дипфейков заставило исследователей по всему миру заняться разработкой ответных мер. Им предстояло создать методы, способные выявлять поддельные изображения.

Большинство из предложенных методов были основаны на извлечении существенных признаков, встречающихся на изображениях, применении классификатора двоичного кода снимков и глубокого машинного обучения для определения, является ли изображение поддельным или реальным.

Большинство исследований по выявлению дипфейков, проведенных за последние пять лет, было сосредоточено вокруг идентификации различных артефактов, встречающихся на видеоизображениях. Исследователи искали несоответствия в окружающем освещении, сравнивали биометрические характеристики оригинала и копии, пытались проанализировать расхождениях по времени, даже использовали знания об инстинктивных микродвижениях лица и тела, чтобы выявить дипфейк у цифровой копии.

Недостатком этих методов было то, что используемые ими характеристики можно истолковать и техническими ограничениями при съемке. Например, они могут появляться в результате плохого сжатия видеокодека, что способно приводить к неконтролируемому появлению различных бликов и артефактов, которые мешают применять выбранные методы обнаружения дипфейков.

DepthFake — метод выявления дипфейков по разности глубин пикселей

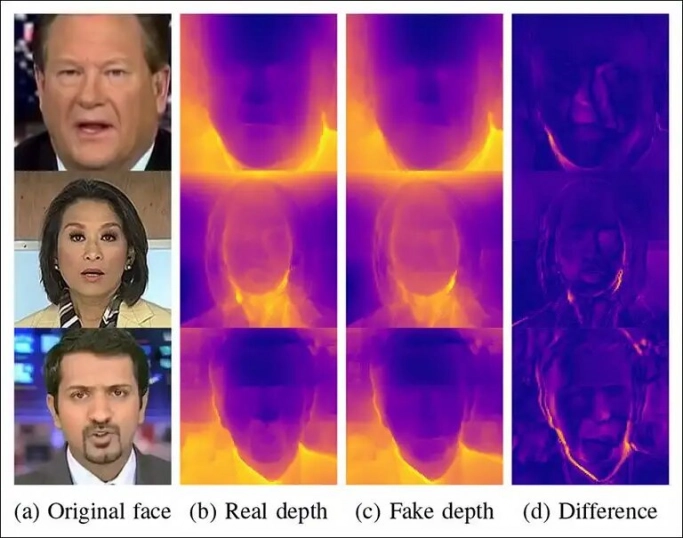

Исследовательский проект под названием DepthFake, осуществленный учеными из Италии, использует качественно иной метод для выявления дипфейков. Он основан на анализе RGB-снимков и оценке глубины каждого пикселя изображения. Уже первые его результаты указывают на то, что этот метод может существенно повысить точность выявления подделок.

Анализу подлежит информация о глубине для каждого пикселя изображения в области лица. Эта информация берется из RGB-снимков, с использованием специального оптического датчика глубины. Таким образом создаются оригинальные снимки с расширенным набором параметров, которые применяются для машинного обучения с базой аналогичных дипфейковых снимков. После проведенного обучения построенная глубокая нейронная сеть позволяет выявлять дипфейки на снимках с отсутствующим оригиналом.

Примеры расчета карт глубины и разницы между реальными и поддельными изображениями

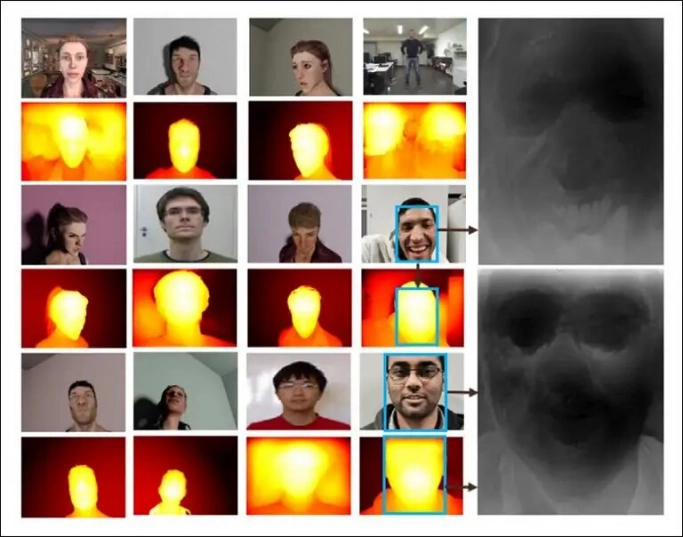

В ходе исследования использовалось несколько различных моделей нейронных сетей. Хорошие результаты показала сверточная нейронная сеть с архитектурой Xception, которая отличается высокой компактностью.

Приемлемые результаты продемонстрировала и предварительно обученная сеть с архитектурой MobileNet, которую Google добавила в 2017 году в TensorFlow. В ней используются принципы, похожие на Xception, что позволяет сделать нейромодели еще более компактными и пригодными для практической реализации задач компьютерного зрения на базе мобильных телефонов или IoT-устройств, обладающих крайне ограниченными запасами памяти и слабым процессором.

Сейчас перед исследователями стоит задача добиться снижения задержки при получении результата оценки. Метод должен позволять обнаруживать дипфейки в реальном времени. В дальнейшем это позволит выстроить защиту против мошенничества на базе дипфейков, частота которых нарастает. Одним из недавних примеров стала мошенническая атака против криптобиржи Binance.

Снижению времени задержки может способствовать то, что метод DepthFake, как оказалось, не требует обязательного использования полноцветных, «тяжелых» изображений для выявления фальшивых снимков по карте глубины. Данный метод удивительно эффективно работает и с черно-белыми изображениями, где информация о глубине кодируется через оттенки серого.

Ранее исследователи применяли для аналогичного рода задач датасет FaceForensic++, где для принятия решения использовались цветовые артефакты. Новый метод DepthFake обеспечил сокращение времени поиска оценки в среднем меньше на 3,2–11,7%.

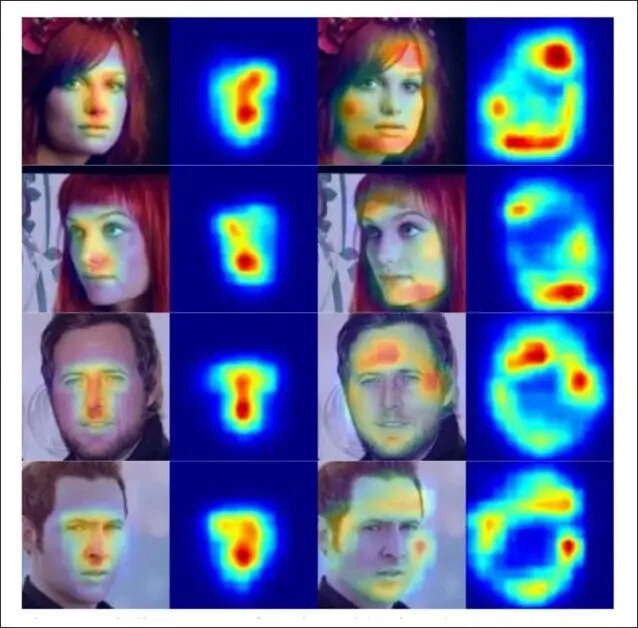

Визуализация «карт заметности» лица

Отмечается также, что особенностью DepthFake является то, что он выстроен на оценке внутренних областей лица, таких как глаза, нос и рот.

Существуют и другие методы выявления дипфейков, основанные на оценке периферийной области лица, его формы. Но подобные методы требуют значительно большего объема обучающих данных, поэтому их применимость ограничена только селебритис.

В то же время метод DepthFake в целом может успешно работать с изображениями обычных людей, позволяя оценивать видеоконтент по карте глубины в реальном времени.

Годятся даже обычные смартфоны

Самое интересное в отношении метода DepthFake в том, что для нее применяется оптический датчик глубины, имеющийся в наборе фотокамер у многих моделей смартфонов. Первоначально они предназначались для построения цифровой карты окружающего пространства в AR-системах и для улучшения качества фотоснимков. Новый метод DepthFake открывает перед ними и новые возможности. Вероятно, в будущем это позволит использовать смартфоны для выявления дипфейков в реальной жизни.

Реальные карты глубины по методу FaceDepth

Опубликовано 23.11.2022