Доверяй, но проверяй: как управлять качеством больших данных

Качество данных – точка опоры для многих процессов, связанных с обработкой информации для различных целей – аналитики, подготовки отчетности, создания хранилищ данных, автоматизации систем управления рисками и других направлений деятельности современных компаний.

А если мы говорим о внедрении BigData-решений, то данные поступают из различных источников в структурированном и неструктурированном виде. Они должны быть очищены, отфильтрованы, объединены, разделены на домены, сохранены, причем со всей историей изменений. Такие действия выполняются в режиме реального времени, в пакетном режиме или параллельно и предпочтительно в облаке. Поэтому вопрос качества данных в подобных проектах имеет первостепенное значение.

Очевидно, что идеальное их качество обеспечивается за бесконечное время и при наличии не менее «бесконечного» бюджета. И с учетом объема данных, которыми оперируют компании сегодня, важной задачей становится управление качеством потока информации наиболее эффективным и экономичным способом. И скорость появления и обновления данных не делает задачу проще, поскольку классические инструменты контроля их качества предназначены для работы с хорошо структурированной информацией в пакетном режиме.

Количество практически реализованных проектов с применением технологий BigData продолжает расти, это направление ИТ-рынка становится все более зрелым. Соответственно, и заказчики заинтересованы в том, что касается оптимизации расходов. И выверенность качества данных на входе в проект – один из способов решить и указанную задачу в том числе. А также сократить сроки и повысить отдачу со стороны ИТ в глазах бизнес-заказчиков.

Согласно исследованиям Gartner, именно низкое качество данных несет компаниям огромные убытки, исчисляемые миллионами долларов. Это связано с принятием неверных решений, основанных на некачественных данных и результатах их анализа, а также с необходимостью привлечения высокооплачиваемых специалистов в области DataScience для повышения качества исходной информации. Кроме того, это влияет и на сроки выполнения проектов, ведь примерно до 60% времени привлеченным экспертам нередко приходится тратить на очистку и организацию данных.

Слагаемые успеха

Главные слагаемые успеха в процессе проверки качества исходных данных, на мой взгляд, связаны с четко составленным описанием метрик на начальном этапе проекта и последующим контролем на всех шагах их жизненного цикла.

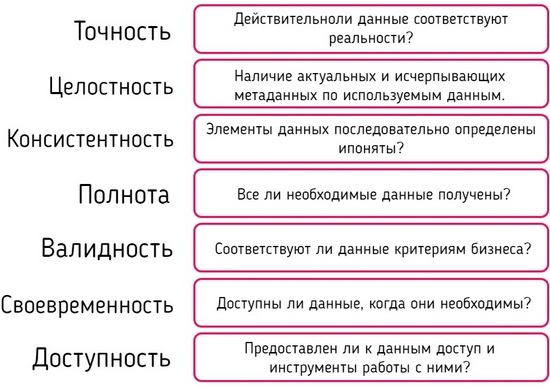

Ниже представлен набор ключевых характеристик качества данных, опираясь на который можно провести первичный аудит. И уже на основе полученной информации принимать дальнейшие решения о необходимости дополнительных шагов, связанных с их уточнением, очисткой и дальнейшей обработкой.

Рис. 1. Набор ключевых характеристик качества данных

За прошедшие несколько лет мы выполнили ряд проектов с использованием стека технологий BigData в организациях финансового и реального секторов. Для банков мы решали задачи по автоматизации подготовки регуляторной отчетности на базе собственного продукта. А для одной крупной транспортно-логистической компании разрабатывали систему, позволяющую управлять остатками на складах в режиме реального времени и, соответственно, планировать загрузку транспорта во временном горизонте на неделю вперед. Охватить столь разные сегменты с точки зрения задач и особенностей деятельности заказчиков нам позволяет применение собственной платформы разработки приложений BigDataс с преднастроенными компонентами для реализации типовых задач (сбор и трансформация данных, контроль качества данных и т. Д.). Она помогает существенно сокращать сроки выполнения проектов и снижать их стоимость именно за счет того, что не требуется привлечения дорогостоящих и дефицитных для ИТ-рынка разработчиков.

Имея немалый опыт, могу отметить, что выверка качества данных – один из важных элементов, требующий столь же пристального внимания, как и все остальные аспекты реализации сложных ИТ-проектов.

На рис. 2 схематично изображен жизненный цикл данных при их обработке инструментами BigData. И именно качество данных – тот фактор, который влияет на выбор способа управления ими на протяжении всего жизненного цикла.

Рис. 2. Жизненный цикл данных при работе с технологиями BigData

Управление качеством данных включает добавление дополнительных функциональных возможностей на каждом этапе, представленном на рис. 2, с постоянным контролем и мониторингом, который позволяет избежать потери качества.

Модель управления качеством данных

Мы предлагаем нашим заказчикам использовать целостную модель управления качеством данных, охватывающую важные аспекты этого процесса на протяжении всего жизненного цикла. Из практики наших проектов оптимальной моделью является внедрение готовых компонентов, на базе которых далее можно расширять состав и порядок анализа и контроля качества данных.

Типовой план фазы проекта, связанной с управлением качеством данных, состоит из следующих шагов:

-

Профилирование данных. Определение и измерение базовых метрик качества первичных данных.

-

Внедрение «коробочной» функциональности платформы.

-

Внедрение процесса улучшения качества данных (DQ):

-

реализация дополнительных правил DQ;

-

определение административного процесса управления DQ;.

-

выявление контрмер для типовых ошибок DQ.

- Внедрение мониторинга DQ:

-

отчеты DQ состояния и панелей;

-

оповещения для метрик DQ;

-

автоматические задачи пользователям для коррекции данных.

- Постоянный мониторинг и улучшение DQ (рис. 3).

Рис. 3. Схема мониторинга и улучшения качества данных

Безусловно, каждая организация, которая занимается внедрением BigData-решений, со временем начинает задумываться о способах оптимизации сроков, затрат и необходимых ресурсов. Именно в такой момент вопрос с обеспечением качества исходных данных становится наиболее острым. На помощь в этой ситуации может прийти опытный в этой области ИТ-партнер, имеющий доступ к экспертизе, полученной в ходе выполнения проектов для заказчиков разного масштаба и из различных отраслей. По крайней мере наш практический опыт в области внедрения BigData-решений и управления качеством данных говорит о том, что мы идем в верном направлении, помогая клиентам в реализации их задач с учетом конечных сроков и имеющегося бюджета.

Опубликовано 16.01.2019